«Headline

Author

ROCK ON PRO

渋谷:〒150-0041 東京都渋谷区神南1-8-18 クオリア神南フラッツ1F 03-3477-1776 梅田:〒530-0012 大阪府大阪市北区芝田 1-4-14 芝田町ビル 6F 06-6131-3078

名古屋芸術大学 学生によるオーケストラ・バイノーラル・ライブ配信 ~ Dolby Atmos / 360 Reality Audio / AURO-3D ~

名古屋芸術大学 学生によるオーケストラ・バイノーラル・ライブ配信

~ Dolby Atmos / 360 Reality Audio / AURO-3D ~

Text by 名古屋芸術大学 サウンドメディア・コンポジションコース 長江和哉

2021年1月から8月にかけて3 回に渡り、私が録音を教える本学サウンドメディア・コンポジションコースの学生が中心となり、本学オーケストラのコンサートをバイノーラル音声でライブ配信した。本コースは、作曲、録音、音響を学び、新しい時代に必要となる音楽表現を研究していくコースであるが、このようなコンサートのライブ配信を初めて行ったのはコロナ禍が始まった2020年の3月、本学ウィンドアカデミーコースによるコンサートの際に、学生有志が身の回りにある機材を用いて行ったことが始まりである。

その後、2020年夏に配信の基本的な機材を揃え、2020年10月より音楽的な音声や映像によるライブ配信を目指し、コンサートごとに参加者を募り、その都度配信チームを編成し、この1年半で7回のライブ配信を行ってきた。2021年1月からは、研究のために「何か新しいこと」にトライできたらということで、音声は通常ステレオとバイノーラルと2 つのミックスをリアルタイムに作成しライブ配信を行った。筆者は、これらの取り組みを10月20日から23日に行われた、AES Fall Online 2021 Conventionで、ARTSRIDGE 濱﨑公男氏、東京芸術大学 亀川徹氏、WOWOW 入交英雄氏とともに「Next Generation Audio forAdvanced Music Creations and Distributions – Part 2」と題したワークショップで発表したが、今回はProceed Magazineの読者の皆さんにもその詳細をレポートさせていただきたい。

コロナが私たちの生活を激変させた2020年。芸術大学である本学も、慣れない画面越しでのオンライン授業で前期が始まり、教員、学生とも、パソコン、スマホ、カメラ、マイク、スピーカー、イヤホンなどの機器と毎日接する暮らしが始まった。そんな中、演奏実技や実習系の科目は前期の途中より対面授業となり、人と人のリアルなコミュニケーション、そして、そもそも音楽とはどのようなものであったかを再確認した時間となった。

本学では毎年様々なコンサートを企画しているが、その中でも、コロナ禍の中で最初に行われることになった2020年10月22日のオーケストラコンサートは、有観客を予定しながら、コロナの状況が悪化した場合を考慮して配信も同時に行うことが夏頃に決まった。そもそも本コースは、作曲、録音、音響を学ぶコースであるが、学生達がカメラや映像機材を組織することでコンサートのライブ配信ができるのでは、というアイデアはどこからとなく出てきた。そして、2020年夏にビデオ・スイッチャー ROLAND V-1 SDIを導入し、すでにあったSonyの4Kハンディカムを用いながら、HDMIをSDIに変換し50m伝送するケーブルドラムを自作するなどして配信機器を整えた。

振り返って考えてみると、このアイデアは教員である私自身が、オンライン授業のためのカメラや映像周辺機器を組織した経験がなければ敬遠していたかもしれない。なぜならコロナ以前は全く映像配信の知識はなかったからである。そして、この配信プロジェクトには多くの学生が参加してきたが、このコロナ禍でのオンラインでのコミュニケーションという経験がなければ、学生もこれほど映像配信に興味を示さなかったかもしれない。今、改めて振り返ってみるとこれらの配信はコロナ禍の副産物なのかもしれないと感じている。

2020年から2021年夏にかけて、本学のスタジオのPro Tools システムを14年間使用したPro Tools HD 192 I/O からPro Tools HD HDX MTRXシステムに更新した。この際に、5.1chであったスピーカー環境をCR1は7.1.4ch に、CR2は5.1.4ch に変更した。これらシステムにおける更新のほとんどは、学生と一緒にカスタマイズしながら行った。その後、このスタジオを用いて2020年度の卒業制作では数人の学生が3D Audioの作品に取り組み始めた。今回のバイノーラル配信を始めようとしたきっかけはコロナのみではなく、本学スタジオのシステム入れ替えにも関係があるように感じている。

📷 CR1は、7.1.4 Genelec 8330 11本のシステム。CR2は5.1.4 L-C-R 8030 LS-RS 8020、トップスピーカー4つは8020を設置。Dolby Atmos Production Suite、360 Reality Audio Creative Suite、AURO-3D Creative Tools Suite & Auro-HeadPhone が動作可能な環境となった。

📷 2020年8月、CR1のPro Tools HDXのインストールの様子。この時のPro Toolsの入れ替えはROCK ON PROの前田洋介氏にサポートいただきながら行ったが、2021年8月に行ったCR2の入れ替えは私たちのみで行うことができた。

2020 年10 月に三井住友海上しらかわホールで行った1 回目のオーケストラライブ配信は無事に終了し、2 回目の12 月に愛知芸術劇場コンサートホールで行なったライブ配信も同様に無事に終えることができた。そして、3 回目となる2021 年1 月のコンサートでは、もう一歩進んだ要素をライブ配信に取り入れると良いのではと私から学生に提案した。本来は3D Audio でライブ配信ができたらと思ったが、まだマルチチャンネルで音声を伝送するのは難しい。そこで、私たちは3D Audio 制作ツールの制作の補助や確認のためとなるバイノーラル出力を、そのままライブ配信の音声として使用することはできないかと考えた。

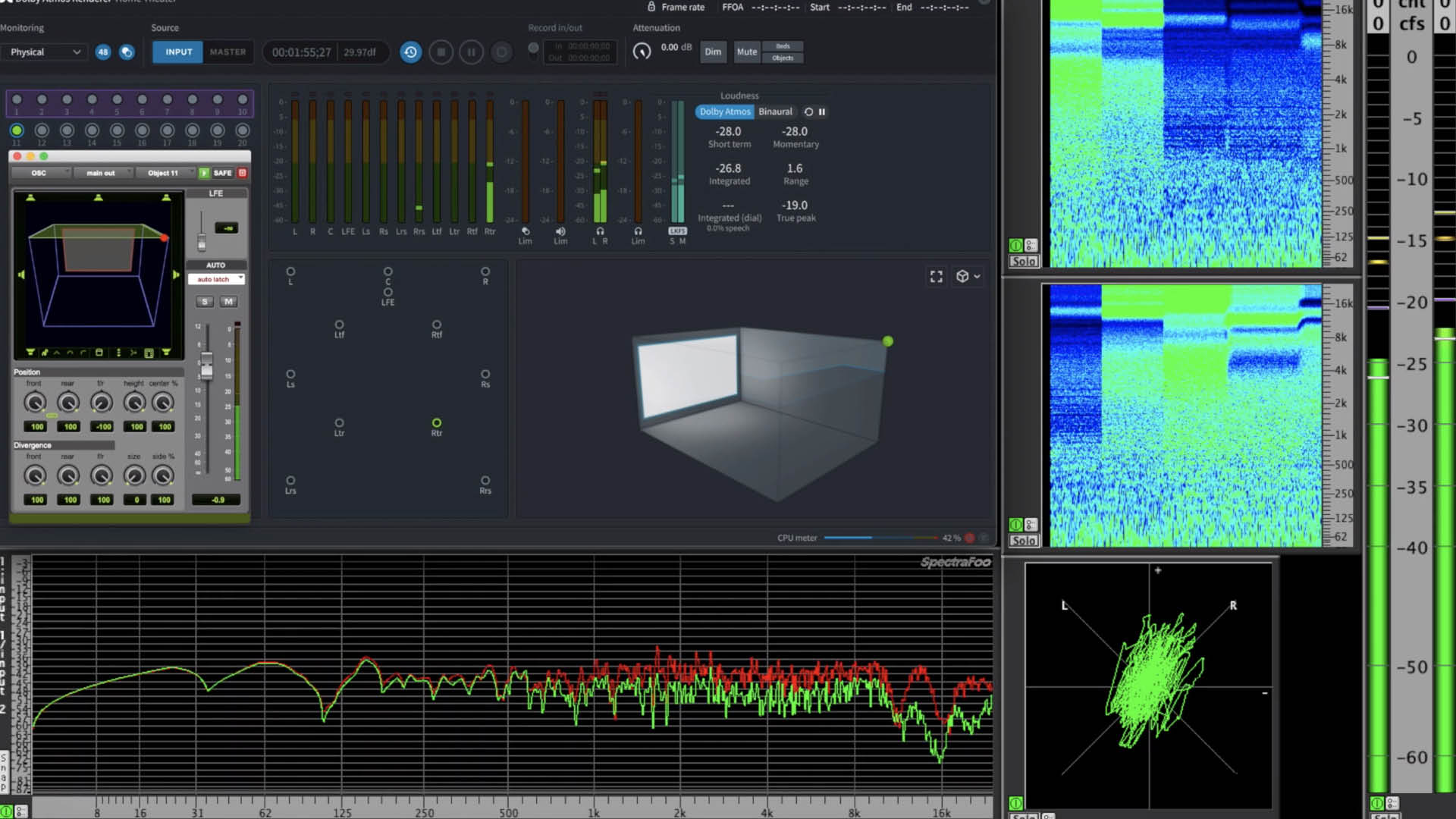

まず最初に、本学が2020年に導入したDolby Atmos Production Suite(DAPS)を用い、学生とともに以前行われたコンサートのマルチトラックファイルを別のPro Toolsより再生しながらMADI経由で各マイクの信号を入力し、ライブバイノーラルミックスをすることができるかのテストを行なったが、それほど困難なく実現できることがわかった。その後、私たちは様々なストレステストを行った。DAPSを用いたライブバイノーラルミックスは、Pro Toolsで録音しながらインプットスルーした信号をDAPSにセンドしバイノーラル処理させ、Pro Toolsにリターンするという、Macにとってはかなりの負荷になることとなるが、そのストレステストを事前に行うことで、「何を行ったらシステムがハングするか」を見極めることができた。このような方法で1月29日は、Dolby Atmos Production Suiteでライブ配信を行った。その後、そのほかのツールでも配信を行いたいという意見が学生から出て、6月3日は360 Reality Audio Creative Suite、8月9日はAURO-3D Creative Tools Suite & Auro-HeadPhoneを用いてライブ配信を行った。

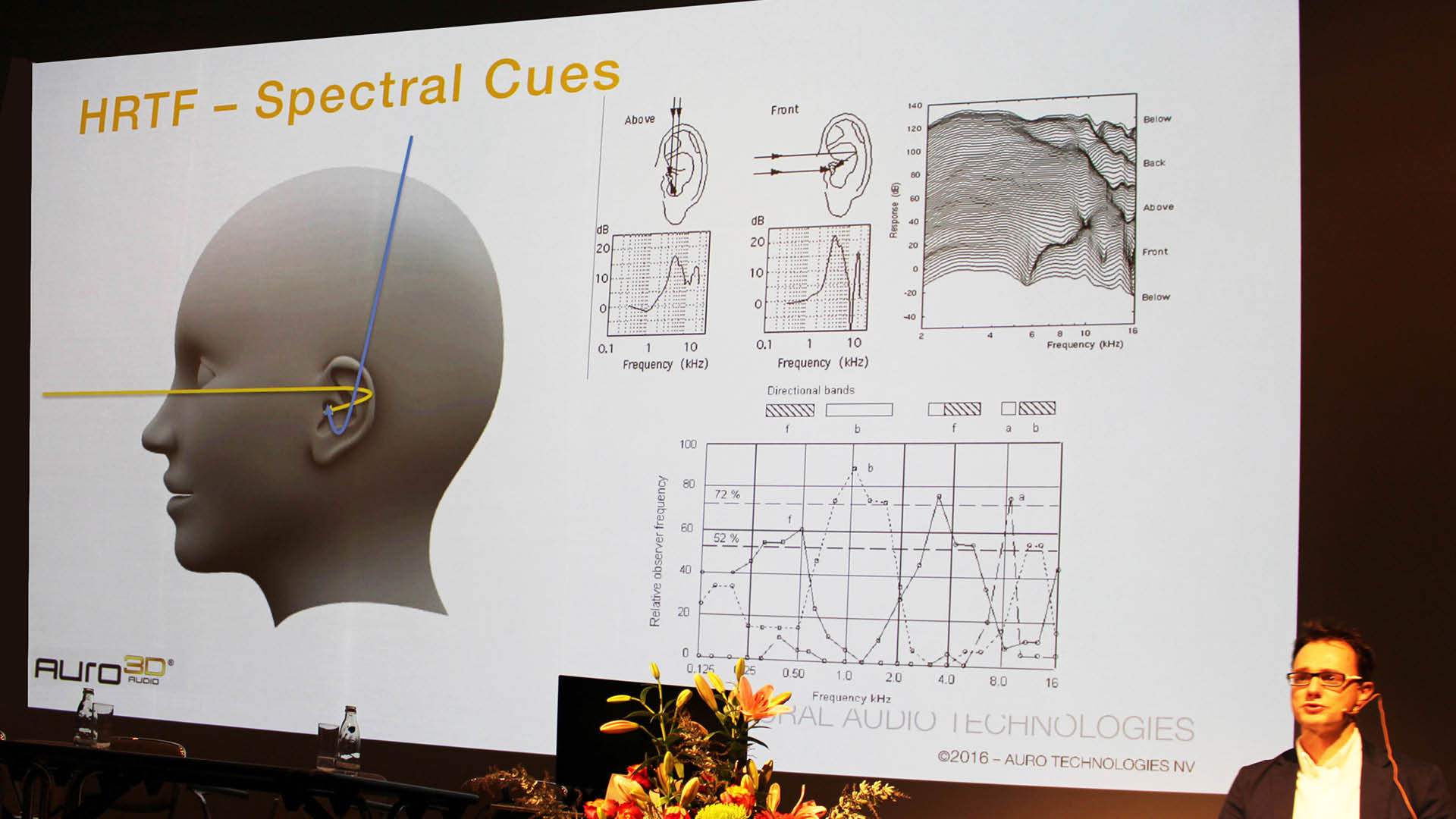

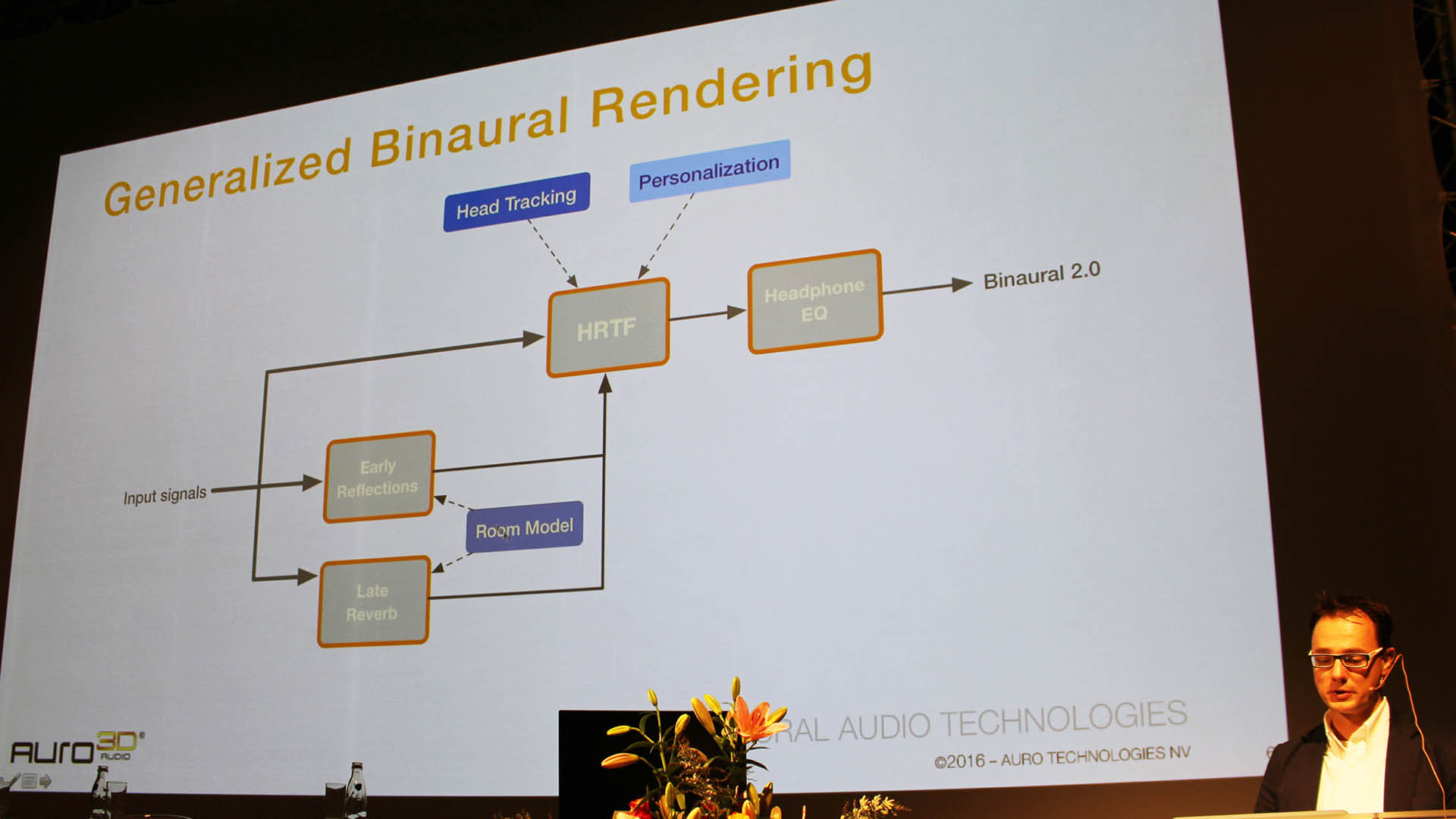

私たちは、バイノーラル3D Audio制作ツールの中でどのようにバイノーラル信号が生成されているかを知る必要があると考えた。バイノーラル音声を作成する方法は、バイノーラルマイクで集音するか、マルチマイクでミキシングされた信号を3D Audio制作ツールを用いて処理するかの2つ方法がある。バイノーラルマイクはマイクのみで完結するが、楽器ごとにバランスを取ることは困難である。となると必然的に3D Audio制作ツールでとなるわけであるが、それらはいったいどのような仕組みであるか?これらのツールの中身はいわゆるブラックボックスであるが、これまで筆者が行った研究では、大きく分けて2つの処理がなされているように察している。

その一つ目がEQ、つまり周波数ドメイン、そしてもう一つがリバーブやディレイと行った時間ドメインである。まず、周波数ドメインについて、それは、DAWにおける各トラックの信号をステレオのようにそのまま出力させるのではなく、その定位を実現するために、頭部伝達関数=HRTF(Head related transfer function) という、音が人間の鼓膜に届くまでの、耳介、外耳道、人頭および肩までふくめた周辺物によって生じる音の変化の伝達関数から導き出されたEQ処理がなされる。そして、時間ドメインについて、再生はヘッドフォンでヘッドホンではあるが実際には部屋で聴いているような印象になるように、リバーブの付加やディレイが用いられ空間的な制御がなされていると察している。

そして、私たちはそれらを具体的に知るために分析を行った。方法はDAWよりピンクノイズを出力し、バイノーラル処理された音声をDAWに戻し、HRTFのEQカーブを分析。また、AUDIO EASEAltiverb 7のリバーブサンプリング用のスイープ音を出力し、付加されるリバーブなどを分析した。その結果、3つの3D Audio制作ツールのそれぞれの処理は三者三様であることがわかった。

📷 ピンクノイズを用いた、Dolby Atmos Production Suiteでのバイノーラル処理研究の様子。距離の設定はmid。トップレイヤの一番後ろに音源を定位した際は、このような周波数ドメインでの処理がされる。同様の方法で、360 Reality Audio Creative Suite、AURO-3D Creative Tools Suite & Auro-HeadPhoneを用いて研究した。

その後、かつて収録したマルチトラックを用いて、どのようにミックスすると音楽的な音色がありながら立体感を得られるかということを検討した。具体的には、Dolby Atmos Production Suiteは、トラックごとにバイノーラル処理するかしないかを選択でき、near mid farという3 つの距離を設定することができる。私たちはその組み合わせについて検討した。1. バイノーラル処理しないもの 2. 全てのトラックをバイノーラル処理したもの 3. メインマイクLCR、HL-HR、Vnのスポットマイクのみバイノーラル処理しないもの、これら3つのミックスを作成し比較した。

その結果、音楽的な音色という観点から、すべてのトラックをバイノーラル処理することが常に良いとは限らないことがわかった。 そこで、標準ステレオとバイノーラルのミックスは、まず全く別のミックスを作成する必要があること、また、メインマイク、ルームマイクについて、バイノーラルで多くのルームマイクを用いるとサウンドがコムフィルターの関係で濁ることがわかった。その後、様々な組み合わせを試したが、3Dスピーカーで再生される音源としては多くのルームマイクが必要であるが、バイノーラルではメインマイクから遠く離れたHLS-HRS、つまり、メインマイクと異なる性質を持ったルームマイクとスポットマイク、そしてリバーブも必要であることがわかった。

📷 2021 年1月29日名古屋芸術大学学生オーケストラ with 名古屋芸術大学フィルハーモニー管弦楽団特別演奏会

指揮 : 高谷 光信 ピアノ : 瀧澤 俊(本学学生) 愛知県芸術劇場コンサートホール

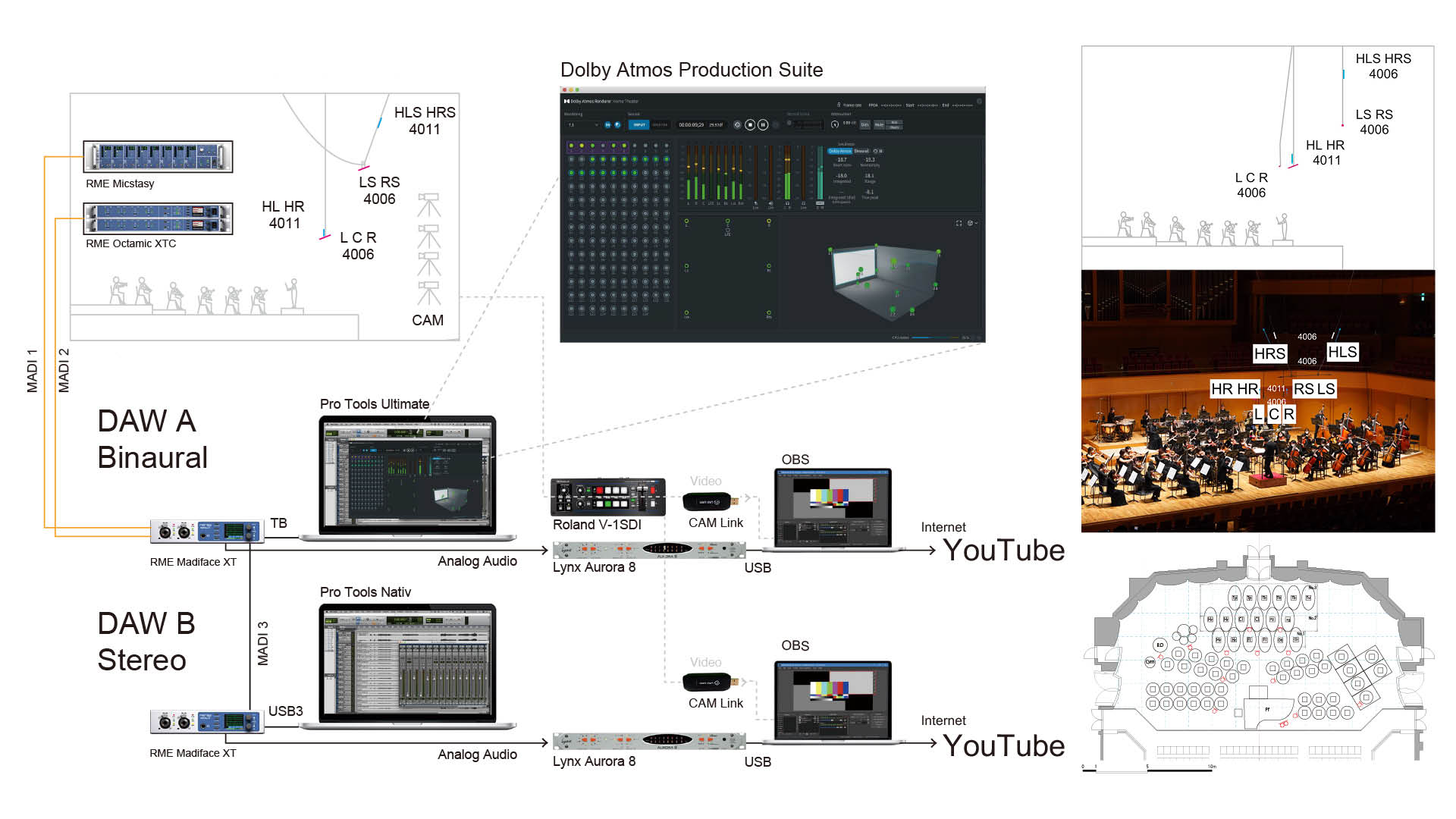

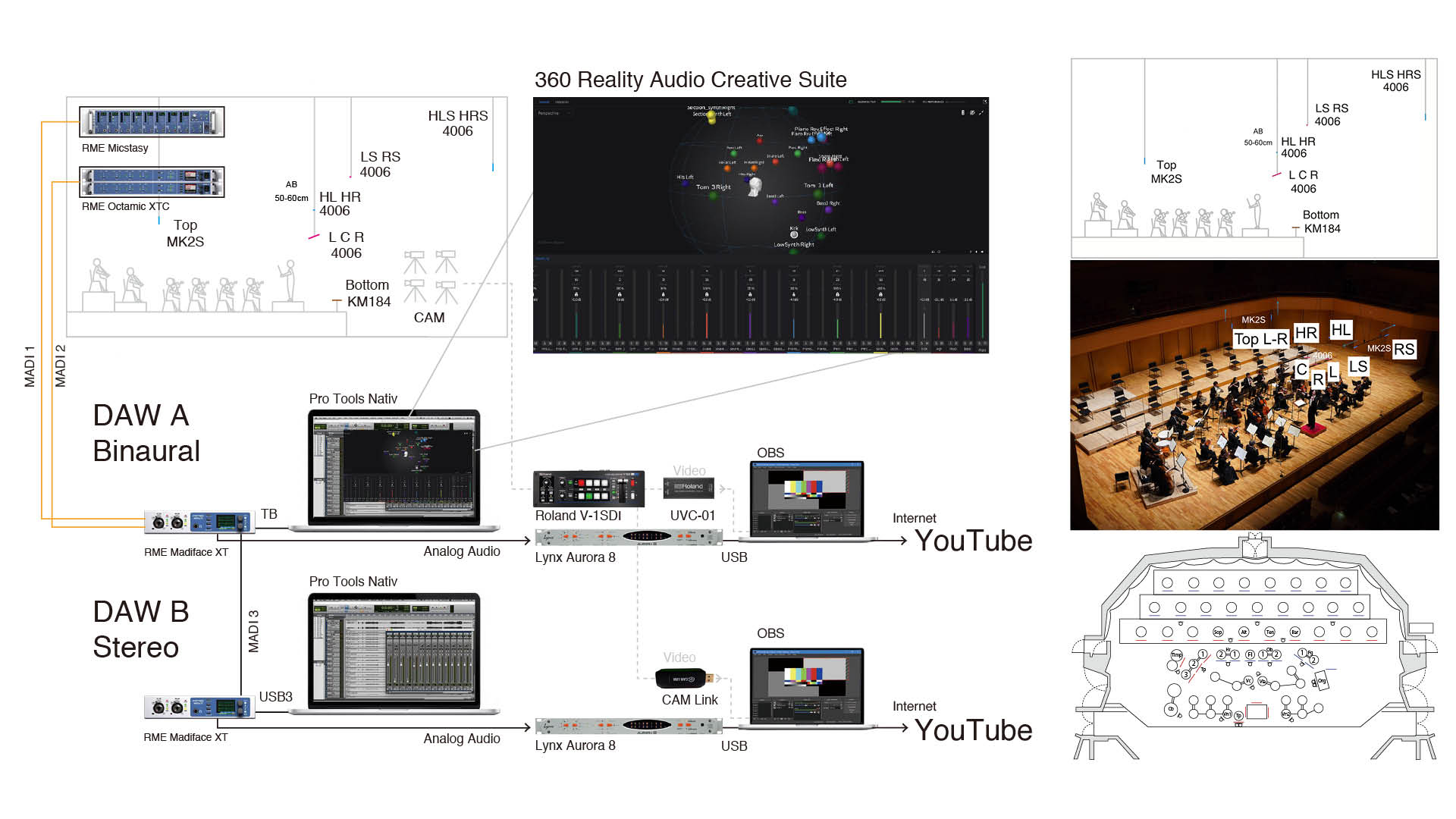

バイノーラル研究を経て、通常ステレオとバイノーラルと2つの動画ストリームを配信するために、写真のように収録配信機材を組織した。メインマイクについて、通常ステレオとバイノーラルでは、L-RとHLS-HRSのみ用いたが、事後に行う3Dスピーカーによるミックスのためにこのようにマイクを配置した。

1:2021/1/29:Dolby Atmos Production Suite

名古屋芸術大学学生オーケストラ with 名古屋芸術大学フィルハーモニー管弦楽団特別演奏会

指揮 : 高谷 光信 ピアノ : 瀧澤 俊(本学学生) 愛知県芸術劇場コンサートホール

>>詳細URL

2:2021/6/3:360 Reality Audio Creative Suite

名古屋芸術大学フィルハーモニー管弦楽団 第7回定期演奏会「オール ハイドン プログラム」

指揮 : 松井 慶太 合唱 : 名古屋芸術大学ハルモニア合唱団 Tp. 宮本 弦 Sop. 伊藤 晴 Alt. 谷田 育代

Ten. 中井 亮一 Bar. 塚本 伸彦 愛知県芸術劇場コンサートホール

>>詳細URL

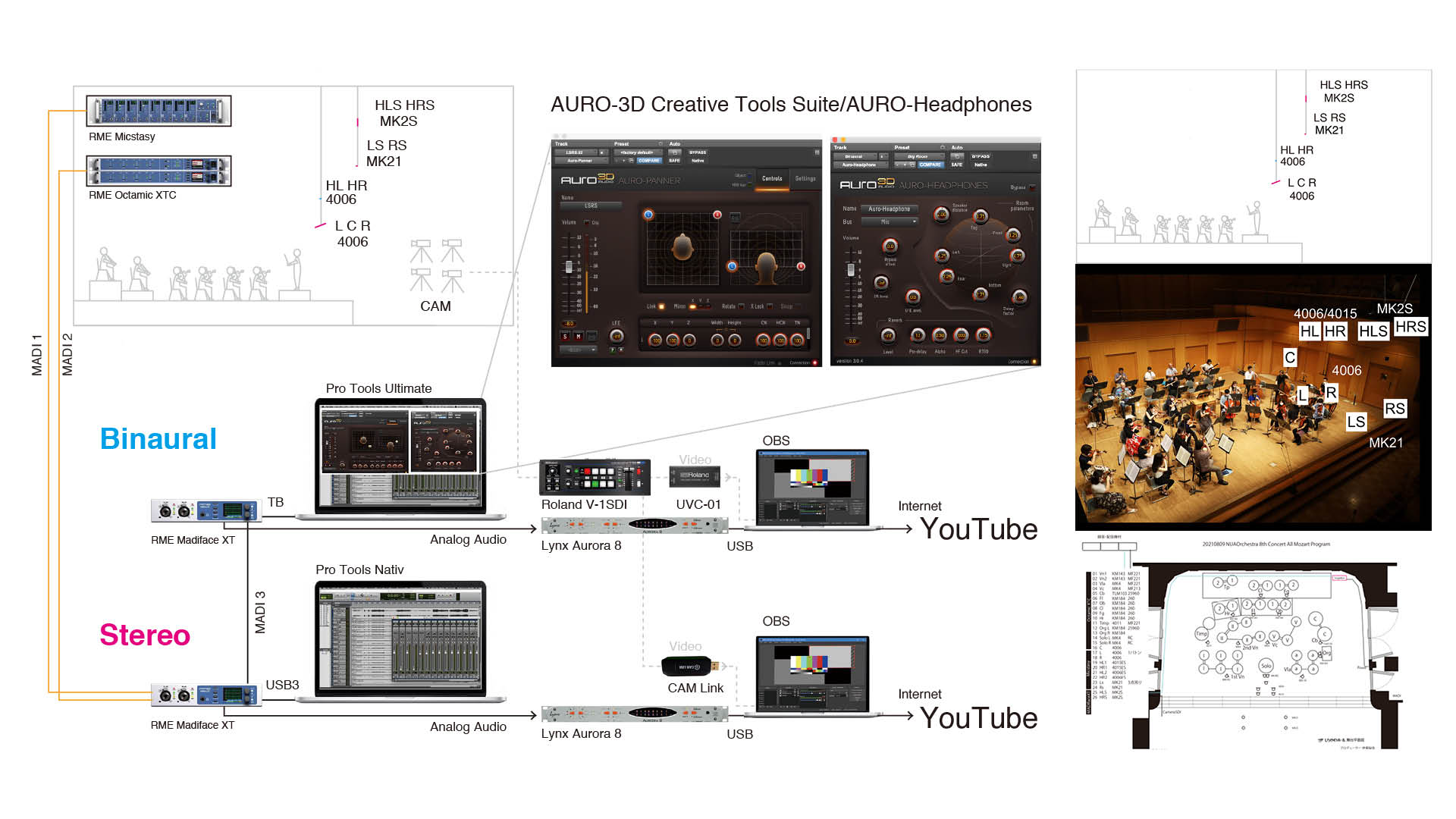

3:2021/8/9:AURO-3D Creative Tools Suite/Auro-HeadPhone

名古屋芸術大学フィルハーモニー管弦楽団 第8 回定期演奏会「オール モーツァルト プログラム」

三井住友海上しらかわホール

>>詳細URL

📷 ステーシの平台の近くに設置したRME OctaMic XTC。ステージボックスはメインマイク用のRME Micstasyとともに2式あり、光ファイバーNeuatric opticalCONを用いMADIface XTと接続している。ステーシの平台の近くに設置したRME OctaMic XTC。ステージボックスはメインマイク用のRME Micstasyとともに2式あり、光ファイバーNeuatric opticalCONを用いMADIface XTと接続している。

バイノーラル研究を経て、どのようなサウンドコンセプトにし、各楽器を定位させると良いかを検討した。私たちは、定位について方法は2つあると考えた。それは、まず客席から舞台を見たように定位にするアイデアと、オーケストラの中にいるようなアイデアである。その両方を試したが、前者はヘッドホンで聴くと後ろは響きしかないように感じた。次に、オーケストラの中心、弦楽器と木管楽器の間にいるような定位を試したが、音楽的にはアレンジがより見通せるようになり、また音響的にも包まれている感じが増した。その結果より私たちは後者を選択した。以下は6月3日のコンサートライブ配信のWeb に記したサウンドコンセプトと360 Reality Audio Creative Suite での音源定位である。

📷 2021年6月3日「オール ハイドン プログラム」の定位図。後方に様々な楽器を定位させた。” バイノーラル・ステレオのコンセプトは「舞台上のオーケストラ中央で聴いているような感覚」。客席で聴いているようなサウンドではなく、オーケストラの弦楽器と木管楽器の間の位置で聴いているようにしたいと考えました。具体的には、弦楽器は前、木管楽器や合唱は後といったように360 度の空間に各楽器の音を配置しました。一方で通常ステレオのコンセプトは、「指揮者が聴いているような感覚」。指揮台上に配置したメインマイクを中心としながら左右と奥行きを表現したいと考えました。”

2020年10月に初めて行なったコンサートライブ配信が無事に終わった後、配信チームのメンバーは、「何度見てもリスナーに観てよかったと満足していただくことができる音楽」とするためには、様々なポストプロダクション作業が必要なことを理解した。映像のスイチングミス、カメラのブレやピントがうまくいかなかったところを他カメラのデータを用い修正、また音声もミキシング操作に起因するバランスがふさわしくないところは再ミックス、他にも演奏が音楽的にふさわしくなかったところはGPのテイクを用いて編集を行う必要もあり、最終的には必要のないノイズを除去するノイズレストレーションも行いながら、アーカイブ版として再度アップすることが必要であることがわかった。1回目の配信ではこれらの作業が大変に感じられたが、2回目以降は作業をどのように分担し、効率よく進めて行くかも考慮することができた。

AES Fall Online 2021 Conventionでの発表のために、8月30日から9月6日まで本コースのFacebookとTwitterで告知し、オンラインでアンケートを行った。3回のコンサート音源の同じ箇所を通常ステレオとバイノーラルと交互に再生し、その印象を返答する方式で行い62人から返答を得た。

結果は、「バイノーラルは、標準ステレオよりも音楽に囲まれていると感じたか?」については、リスナーの69%が同意、もしくは強く同意したが、「バイノーラルは、標準ステレオよりその音楽にとっても好ましいと思ったか? 」については、リスナーの50%が同意、もしくは強く同意した。さらに、バイノーラルが将来において標準ステレオに取って代わるかについては、40%が同意しない、もしくはまったく同意しないという意見が得られた。これらの結果からは、私たちの音源制作方法についてはまだ改善の余地があるということと、やはり人々の耳のかたちは様々で、HRTFデータのパーソナライズ化が必須であるのではということを察することができた。

私たちの最終目標は「より音楽に没頭することができる音響体験」をリスナーに届けることである。コロナ禍で今までとは異なる生活様式となったが、本コースでは、このコロナを機にこれまで行って来なかったライブ配信に取り組むことができた。映像と音声を伴った制作は、教員にとっても学生にとっても未知のことに直面したが、これらに挑戦することは、とても貴重な取り組みとなった。今年度後期は、4回のオーケストラや吹奏楽、室内楽のコンサートの配信を予定しているが、これからも新しいテクノロジーを取り入れながら配信を行って行きたい。最後に、今回のバイノーラル配信の技術サポートの対応をいただいた、ドルビージャパン、ソニー ホームエンタテインメント& サウンドプロダクツ事業本部、Auro Technologiesの各氏に感謝申し上げたい。

配信チームの学生に、ライブ配信に参加してどのようなことを感じたかをインタビューした。

3年:武石智仁さん:テクニカルディレクター担当

本学でのライブ配信は、新型コロナウィルス感染症が流行する初期であった2020年3月に、ウインドアカデミーコースの定期演奏会の配信を学生のみで行ったことから始まりました。その時は十分な機材も知識もなく行いましたが、2020年8月に配信機材が導入され、これまで10回のライブ配信に参加しました。そして、2021年1月からは、何か新しい取り組みをしたいと考え、ステレオ音声だけではなくバイノーラル音声を用いた配信も行うことができました。私自身としては、ここまでの試行錯誤と成長が最も大切な経験となりました。初期の配信ではわからないことが多くありましたが、回数を重ねることで改善することができました。そして、この3回のバイノーラル配信では、技術的な部分をまとめる立場となり、メンバーと一つの配信を作り上げる中で、どのような映像や音声だと演奏がよりその音楽にとってふさわしくリスナーに届けられるかを考えました。回数を重ねるにつれ、単に演奏を伝えるだけでなく、演奏者の思いまでを届けることが大切なのだと気付くことができました。

3年:細川尚弥さん:バイノーラル・バランスエンジニア担当

8月9日の配信の際、AURO-3Dの制作用ツールを用いたバイノーラルミックスを担当しました。ミックスについては、映像とのマッチングのこともあり、前衛的すぎる定位のアイデアは用いることができないながら、ステレオでは作れない独特の空気感を構築することができました。配信中はマウスによるフェーダーワークのみでミックスを行う必要があり慌ただしく感じましたが、「このフェーダーがリスナーに繋がっている」というスリルを感じながらミックスすることができました。実は私は、昨年大学を休学し、半年間 Rock oN Company渋谷店にて働かせていただきました。その際、業界全体で3D Audioの普及に力を入れていることを感じました。そして、今回初めてバイノーラルのミックスに取り組むことができましたが、初めてシステムに触れた際は、通常ステレオとは異なり考えなければならないことが多く難しい印象でした。ただ、今回のミックスのコンセプトはステレオミックスからの拡張をしていく方法であったので、可能性とやりがいを実際に肌で感じることができました。今後は配信とバイノーラルを掛け合わせることについて深く考え、勉強していきたいです。

3年:澤田智季さん:バイノーラル・バランスエンジニア担当

私はこれまでに何度かライブ配信に参加させていただきました。1月29日の際にはバランスエンジニアを担当いたしました。本番ではステレオのミックスを担当しましたが、ポスプロダクションではバイノーラルのミックスを行いました。バイノーラルのミックスは通常のステレオのミックスと比べて、「こういう場合はこうした方が良い」というノウハウが無いので、私たちなりの発想で直感的にミックスを行いました。単に「バイオリンの音が後ろから出たらおもしろそうだから後ろに定位させよう」という考え方でミックスをすると前衛的なサウンドになってしまい、オーケストラ音楽には合わないと感じました。バイノーラルをより音楽的に聴かせようと思うと通常のステレオミックスの理解も必要だと感じました。今後、バイノーラルミックスのクオリティを上げるためには、「ステレオ+α」の考え方でミックスをすること、バイノーラルミックスを行うツールへの理解を深めることが大切だと感じました。

3年:伊東桜佳さん:プロデューサー、スイッチャー、バランスエンジニア担当

私はこれまでの配信の中で、プロデューサー、スイッチャー、バランスエンジニア等、様々なセクションを担当しました。音の面では、バイノーラルという新しい方法でステレオ配信とは違う空間感の良さを ” 誰にでも分かりやすく” 伝えることの難しさを感じました。映像の面では、少しのミスもリスナーには気になる点となるため、スイッチャーとしてどう映像を選択していくかに難しさを感じました。音、映像ともにいくら計画を立てていても、本番は予定通りとはいかない分、メンバーとのコミュニケーションを大切にしながら、 ” 今” を配信していくことはとても貴重な経験となりました。さらに私たちが伝えたいものを伝えられる配信ができるよう、これからも研究していきたいと思います。

3年:長谷川伊吹さん:カメラ担当

私はこれまで8回にわたりライブ配信に参加し、様々な役割を経験しましたが、その中でカメラの画角の決め方が一番難しく感じました。例えば、同じ楽器を撮る時でも、同じような画にならないようにするにはどうすれば良いのか、ということを心掛けていました。楽器をアップにした画にするのか、人ひとりの全身が入る程度にアップするのか、パート全体を撮るのかなど、様々な選択肢の中から瞬時にふさわしい画を選択することが難しいと感じました。反面、この活動を行なった1年半の中で、技術力だけでなく、事前準備や楽曲の理解が大切なのだと痛感しました。

1年:新留潤青さん:カメラ担当

私はライブ配信の技術を学ぶために配信チームに参加しました。これまで2回参加して2回ともカメラを担当しました。私の最初の考えは「オーケストラの配信なので視聴する人はまず音を重視しているだろう」と考えていました。しかし、実際のところ特に初めてオーケストラをインターネットで視聴する人にとっては、音よりも映像を大切に感じているのではないかと思いました。つまり、クラシックを聴き慣れていない人に、どんな楽器が何人いるか?、どんな会場にいるのか?という情報を音のみで伝えるのは技術的にとても難しいと感じたからです。しかし、今後、3D Audioがあれば音のみでもそれが可能かもしれません。YouTubeでのライブ配信で音楽を伝送する方法は、普段クラシックに馴染みのない人にも勧めやすく良い方法であると感じました。

3年:碓井陽香さん:スイッチャー担当

私は何度かライブ配信に参加させていただきましたが、そのほとんどがカメラやスイッチャーなどの映像関係でした。スイッチャーをやって感じたことは、” このライブ配信を観ている人にストレスを感じさせず画面を切り替えることがいかに難しいか” ということや、” どのように音楽と映像マッチングさせるか” ということです。映像の切り替え部分は事前にスコアに記し、ある程度決めていましたが、本番で違うカメラの方が良い画だと感じたら臨機応変に変えていくことや、音楽のシーンが移り変わっていくのに合わせて、映像もクロスフェードするなど、その場その場で考えてスイッチングしていくのがとてもスリリングで楽しかったです。

3年:中島琢人さん:プロデューサー担当

私は大学の配信チームでプロデューサーを2回担当しました。その際、1つの演奏会にとても多くの方が携わっていることを肌で感じることができました。そして、コロナ禍でも配信を通して音楽を届けられることにやりがいを感じながら、感謝の気持ちを持って取り組むことができ、最終的にはポストプロダクションを終えるまで、メンバーに支えられながらチームをまとめることができました。このように毎回新しいバイノーラルの技術的な取り組みに挑戦しながら互いに知識を高め合い協力して配信を行うことができ、とても貴重な経験になりました。

*ProceedMagazine2021-22号より転載

*記事中に掲載されている情報は2022年01月28日時点のものです。