«Solution

Author

山之下 朝陽

[ROCK ON PRO Product Specialist Team / Assistant]Immersive Audioを用いた芸術音響作品を創作し国内外で発表を行なってきた経験から、音楽表現を支える最先端の技術を広めるべくROCK ON PROへ。メガネは伊達。

NTT IOWN / 世界初のリアルタイム3D空間伝送実験

取材協力:NTT人間情報研究所

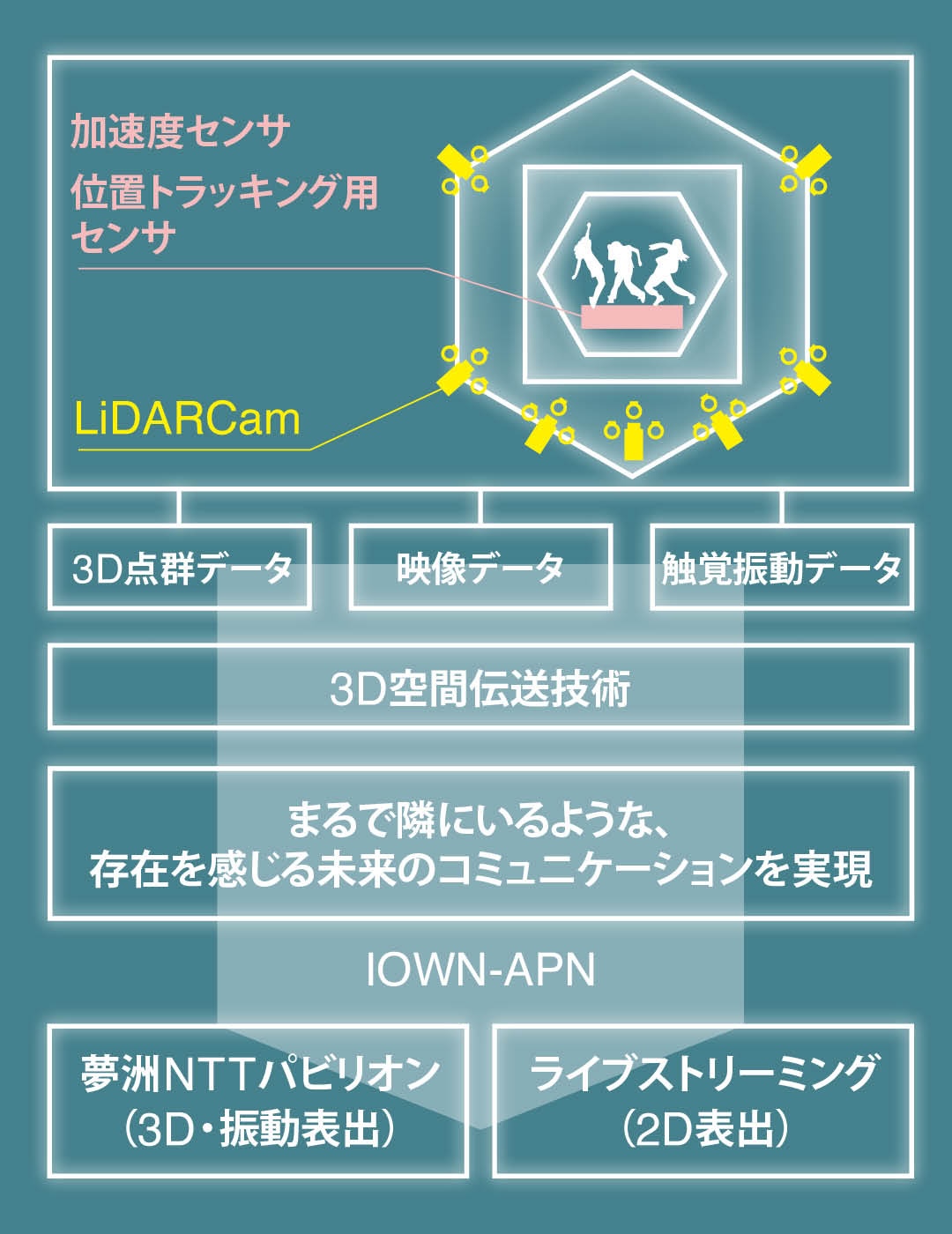

NTTが2030年ごろの実用化を目指し推し進める、次世代情報通信基盤「IOWN(Innovative Optical and Wireless Network) 」。あらゆる情報をもとに個と全体の最適化を図り、多様性を受容する豊かな社会の実現を掲げる構想だ。光を中心とした革新的な技術を活用し、従来のインフラの限界を超える高速・大容量通信や膨大な計算リソースを、端末も含めたネットワークおよび情報処理基盤として提供することを目的としている。

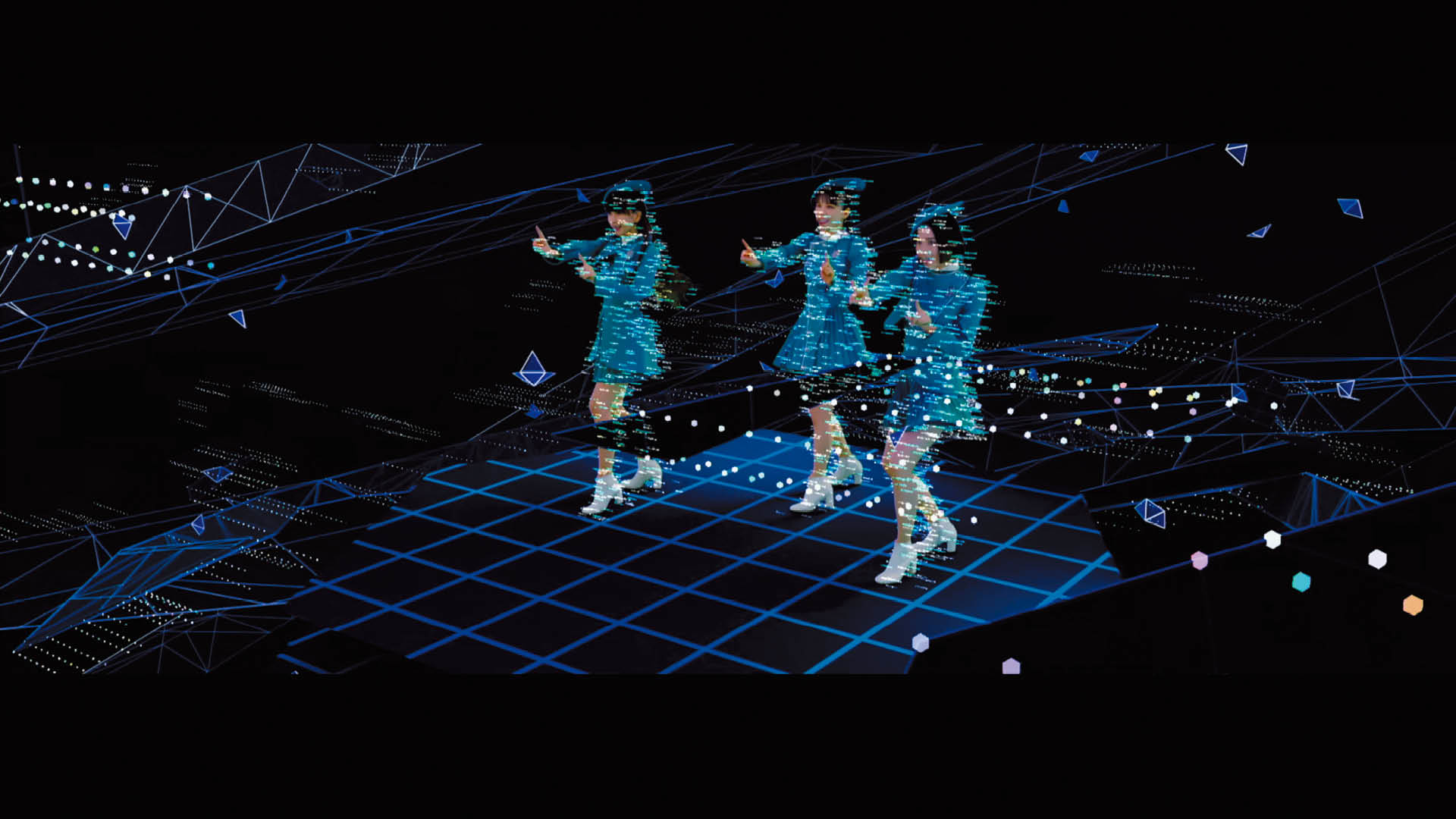

そのNTTが今回、大阪・関西万博のNTTパビリオンで挑んだのが、IOWNを活用した世界初のリアルタイム3D空間伝送実験である。この試みでは、夢洲に設置されたNTTパビリオンと吹田の万博記念公園をIOWNで接続。NTT研究所が独自に開発・保有する「動的3D空間伝送再現技術」と「触覚振動音場提示技術」により、Perfumeのパフォーマンスを“空間ごと”リアルタイムに伝送・再現するという、かつてない挑戦が行われた。これは、2025年の万博と1970年の電気通信館、二つの時代の万博会場を時間と空間の両方で接続し、まるで隣にいるかのような存在感の共有を可能にする未来のコミュニケーションを体現したものである。さらにこのパフォーマンスは、万博会期中、NTTパビリオンのZone 2にて来場者が“時間を超えて追体験”できるという仕組みとなっている。今回は、この世界初の実証実験を支えたNTT人間情報研究所の松元 崇裕氏、草深 宇翔氏、鈴木 督史氏に話を伺った。

📷左よりNTT人間情報研究所 松元 崇裕氏、草深 宇翔氏、鈴木 督史氏

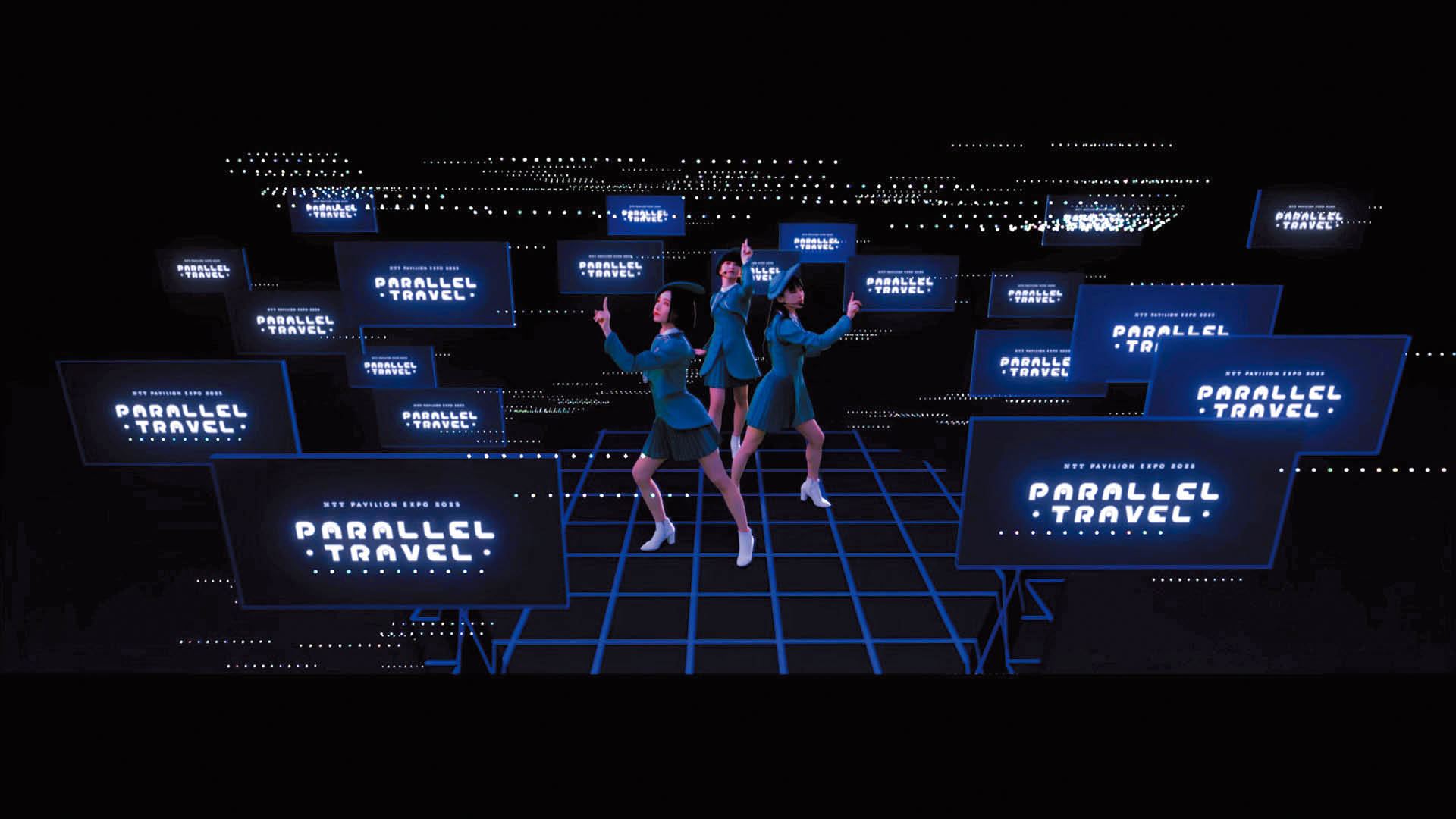

大阪・関西万博にて、NTTパビリオンが体験テーマとして掲げるのは「Parallel Travel」。これは時空を旅する体験を意味し、IOWN技術によって物理的距離を超えた空間共有を実現し、互いに存在を感じ合う未来のコミュニケーションを提示するというもの。まさに近代日本において伝達技術の基盤と革新を担ってきたNTTならではのアプローチである。この壮大なテーマは、Zone 1からZone 3までの3つの建屋によって構成されるNTTパビリオン全体を通じて物語られる。本稿ではその中でも、未来のコミュニケーションの姿を示すZone 2での取り組みに焦点をあて、掘り下げていこう。

Rock oN(以下、R):今回のテーマである「Parallel Travel」の中における、Zone 2の位置付けについて教えてください。

松元:Zone 1では、過去から現在に至るまでのコミュニケーションの変遷を扱っています。しかし、我々は現代においてもまだ “どこか繋がりきらない” 部分が残っていると感じています。だからこそZone 2では、その限界を越えていくような、「未来のコミュニケーションとは何か?」という問いが大きな鍵になっています。

1970年の大阪万博でNTTは、映像の多元中継などの展示を行なっています。ではそこから時代を経てこの2025年では何が見せられるのだろうといった議論から始まりました。その中で、空間まるごと伝送する、そこにある五感(今回でいうと振動による触覚)を含めて、低遅延で相互に繋がるというのが未来のコミュニケーションとして描けるのではと考えました。

IOWN構想の中では、デジタルツインコンピューティング(DTC)にもあたる取り組みです。これは現実空間の写鏡としての「デジタルツイン」をバーチャル空間に存在させるという話で、これまでも渋谷の街並みをバーチャルで再現するといったプロジェクトはありました。これまでは、動きのない3Dデータや、現地の一部センシング情報のみを反映させる事例が主流でした。そうした中、私たちは点群技術を活用し、「動きそのもの」をバーチャル空間に伝送することに挑戦しています。さらに、振動をはじめとするこれまで扱われてこなかった多感覚情報の再現にも取り組んでいます。

R:そこで今回、それら技術を掛け合わせたリアルタイム3D空間伝送実験が企画されたということですね。今回の実験の中でも特に革新的な要素というのはどこにあたるのでしょうか?

松元:これまでもボリメトリックな3D測量を用いた配信などは各地で取り組まれてきましたが、そこでは数秒レベルでの遅延が発生しています。そこを今回我々は約100 msまで縮めようと取り組みました。遅延を考える際に面白いのが、圧縮すればデータ量が減るので細い回線でも速く送れるのですが、その分圧縮の時間が発生してしまうところです。そこで今回はIOWN APN(オールフォトニクス・ネットワーク)という大容量で安定した”最新の回線”を使用することによって、ほぼ非圧縮のデータをリアルタイムで伝送できました。遅延を100msまで抑えることで、配信では双方向の会話が成立しています。夢洲と吹田の距離でこの規模の3Dと振動情報をリアルタイム伝送するというのは初の試みと言っていいかと思います。

今回、低遅延の長距離伝送を実現する基盤となったネットワーク技術が、IOWNを構成する主要技術の一つ、オールフォトニクス・ネットワーク(APN)である。ネットワークから端末まで、すべてにフォトニクスベースの技術を導入し、現在のエレクトロニクスベース技術では困難な、低消費電力、高速・大容量、低遅延・ゆらぎゼロの高品質な伝送を実現する。今回の実験では吹田ー夢洲間、直線距離にしておよそ20kmをAPNにて接続。映像や音声の情報を圧倒的な低遅延で伝送した。APNは既にNTTが実際にサービスとして提供を開始している技術でもあり、リモートプロダクションやライブ中継の他、産業やまちづくりでも運用が始まっている。

松元:今回使用したAPNは吹田市、万博記念公園の電気通信館跡地と夢洲の万博会場をほぼPeer to Peerで繋ぐような構成になっています。万博会場全体では他にもIOWNを用いた試みが実施されているので、会場では一度その中枢のラックを経由して、Zone 2まで接続しました。

R:今回実際に使用したAPN回線のスペックはどれほどですか?

鈴木:容量は100Gbpsです。その中で実際に使用したのはおおよそ25Gbps程になりました。伝送量や障害についてもポート単位で監視をしています。準備期間で設計を詰めていき、本番では問題が発生することもありませんでした。

R:APNの特徴として揺らぎのなさがありますよね。今回、振動伝送で使用されたDanteのレイテンシーを見てもまったくパケットの遅延量が変わらず安定していたのが驚きでした。しかも吹田ー夢洲間で遅延が約700μs、1msを切っているという。

松元:映像伝送やDanteは遅延にシビアですからね。ローカルで接続しているのとほぼ変わりがなく、ネットワークを跨ぐことによる問題も発生しないというのがAPNを使用して一番影響が大きかった部分かもしれません。点群はむしろ伝送の揺らぎよりも高密度化やノイズ除去といった処理の揺らぎの方が大きくなりました。

鈴木:映像チームからもこんなに安定した遠隔回線は無いと言っていただけました。大容量メディアの伝送でAPNは特に使い勝手が良いと思います。

R:長距離の伝送となりましたが、同期はどのように取られたのでしょうか。

鈴木:夢洲、吹田の両拠点にGPSのPTPグランドマスターを設置しました。他ではまず行わないことなのですが、今回3種類のPTPを扱っています。映像用のPTPv2、振動伝送するDante用のPTPv1に加えて、点群センサーであるLiDAR(Light Detection and Ranging)用のgPTPです。gPTPは殆ど自動車系でしか使われていないPTPなのですが、LiDARも同じく自動車のセンサーとして使用されているものなので製品の仕様上扱うことになりました。3種のPTPがそれぞれ混ざらないようにネットワークを設計するのはパズルの様でしたね。VLANでもPTPが流れてしまうとPTPモードのスイッチが止まってしまったりするので、回避させたりといったことをしています。またLiDAR自体は本来1台で使用する想定のものなので、それを複数台組み合わせる際に想定外の挙動をするといった苦労もありました。

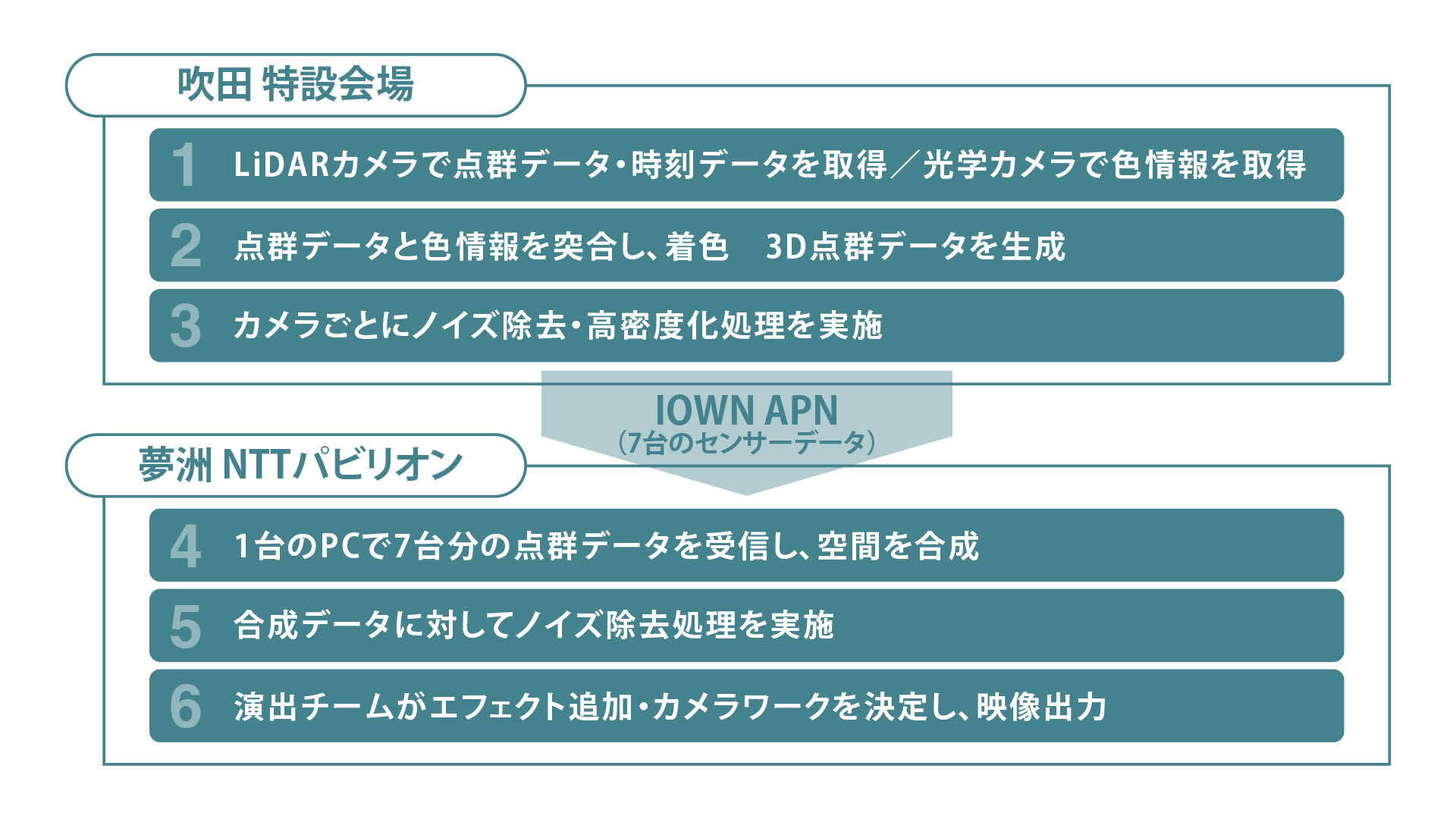

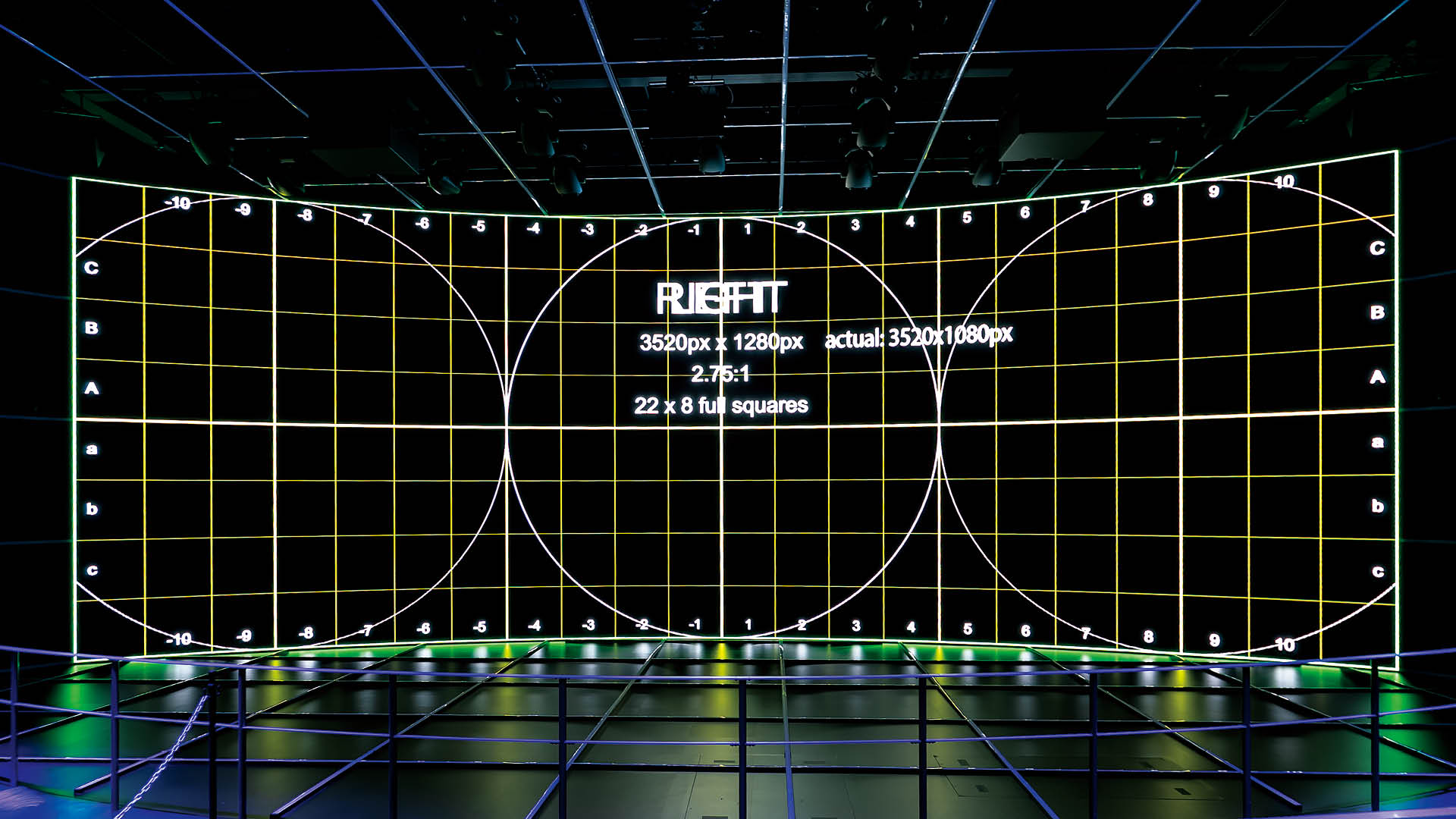

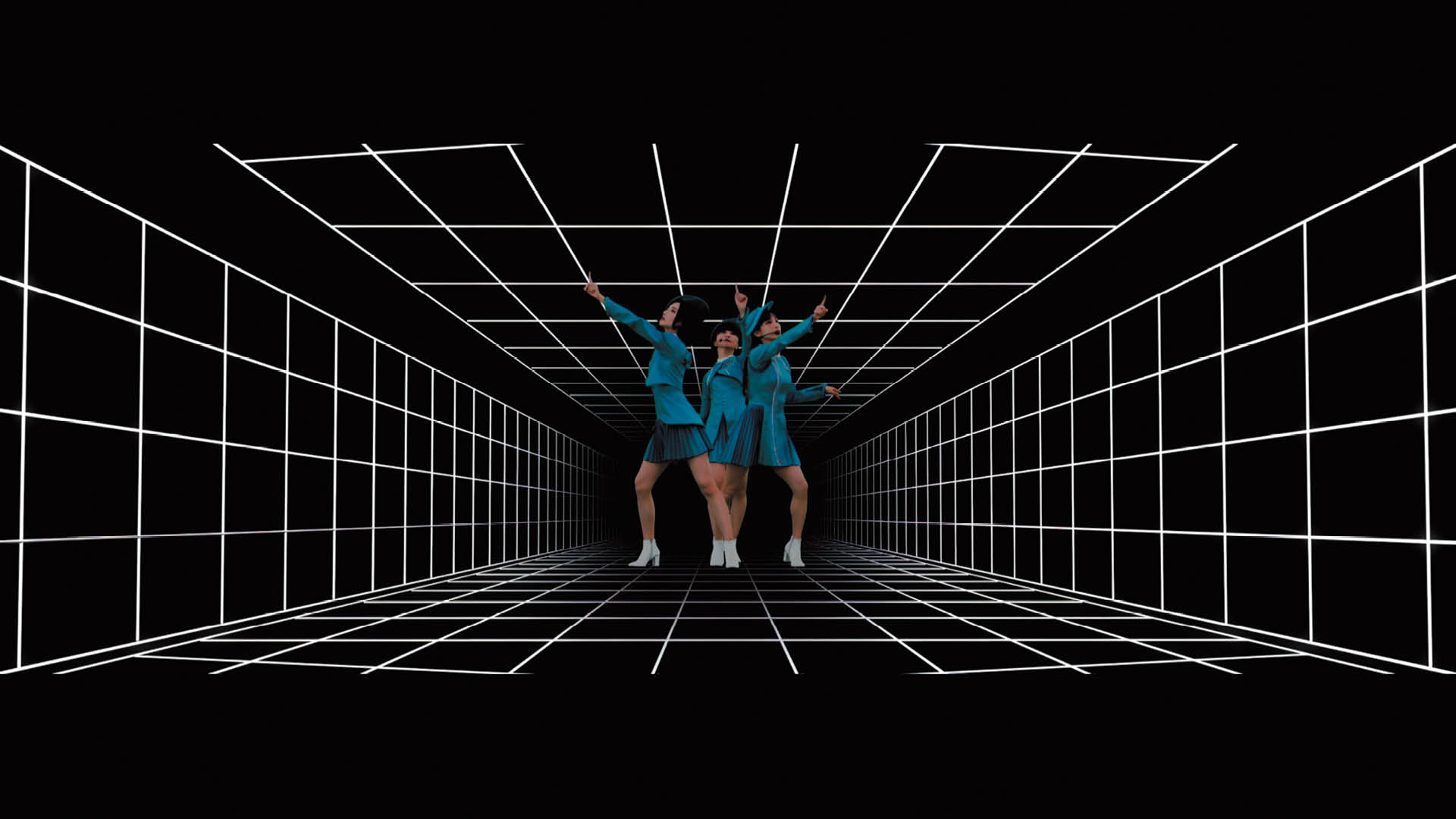

今回の伝送実験では、1970年大阪万博「電気通信館」跡地に設置された特設ステージでのパフォーマンスを計測・撮影し、膨大な3次元点群データおよび画像データを生成。それらをリアルタイムで伝送し、StereoCamによる映像と組み合わせることで、空間全体をまるごとキャプチャし、遠隔地に再現するという試みが行われた。点群データの取得に用いられるLiDARは、レーザー光を用いて物体の形状や距離を高精度に計測する技術であり、取得した情報は「点群データ」として3次元的に構成される。3D映像として目の前に立ち現れるパフォーマンスは、映像再生の域を超え、まさに「空間伝送」といえる臨場感を生み出す。

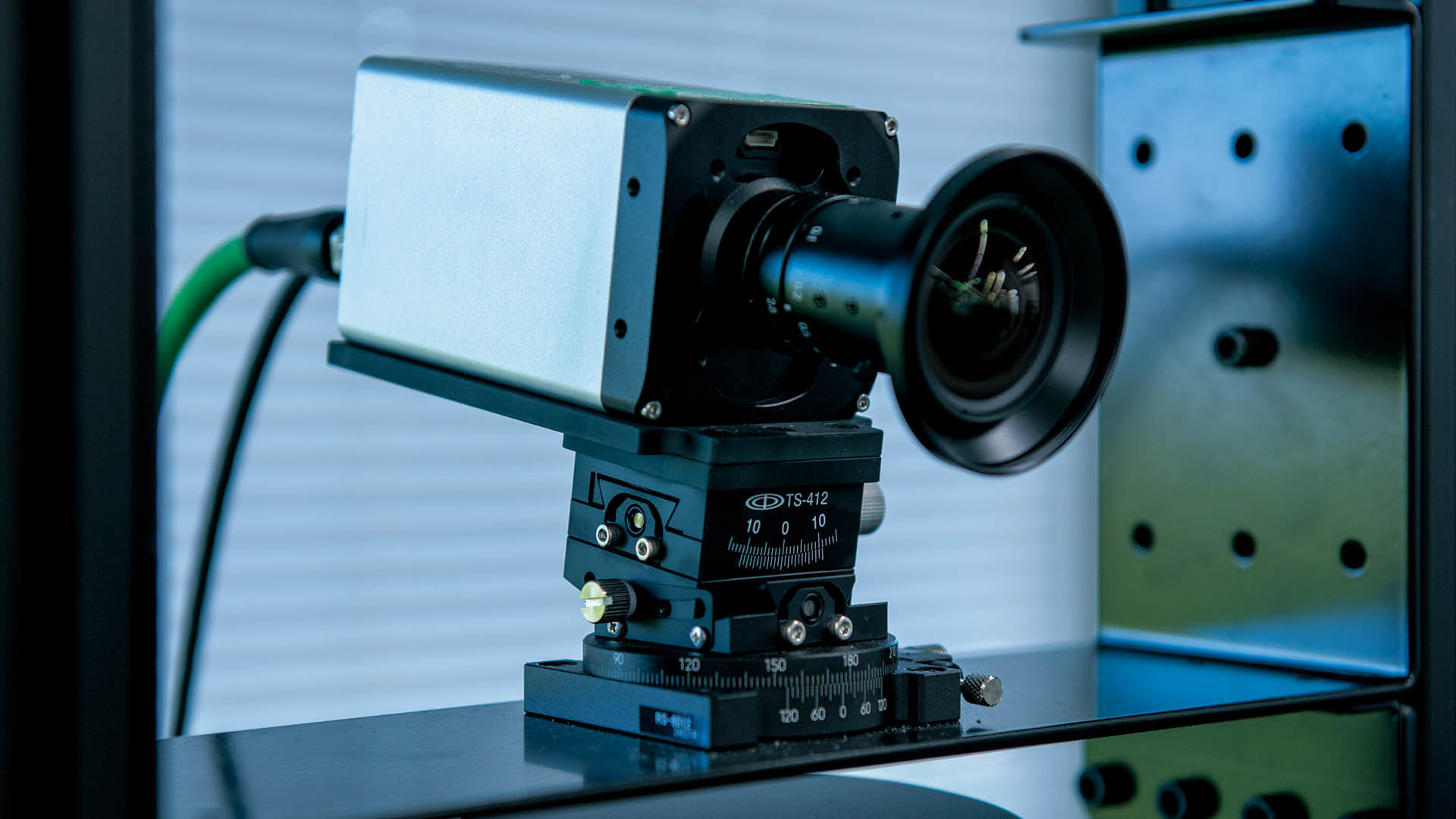

松元:点群センサーは3台のLiDARと1台の光学カメラを1セットとして、パフォーマンスのステージを取り囲むように7セット配置しました。演出面も考えて、前方に5台、後方に2台の構成をとっています。LiDARは回転式なので360度、光学カメラは水平70度ほどをカバーしているので、この配置でも全方向をキャプチャーすることができます。それでも他のカメラや振動用のトラッキングセンサーとの位置取りは難しく、シビアな調整の結果この配置となりました。取得するのが三次元の情報なので、現場合わせではまとまらないだろうと事前に3Dで配置図を起こして綿密に計画しています。

鈴木:他のカメラやセンサーも基本は正面に置きたいものですから、映像カメラに映らない画角ギリギリまでセンサー位置を調整したりとせめぎ合いでしたね。

R:そこは通常のライブレコーディングの現場などでも頻発する問題ですね(笑)。点群センサーであるLiDARを3台1セットとしている理由はどこにあるのでしょうか?

松元:LiDARは1秒間に10回転しか回らないので1台だと10フレームしか情報がありません。それではダンスを撮影するには足りないので、縦に3台を連ねて時間的に回転を33ms、操作線でいうと120度ずつずらすことで1セットで1秒間30フレーム取得しています。ですのでPTP制御ができ、複数台でも干渉しない機種を選定しました。システム全体として、150万個の点を1秒間に30回取得しています。

鈴木:その分レンダリングは大変でした。1セットにつきゲーミングPCを1台用意して処理を行っています。

R:LiDARは台数を増やすほど高品質な点群が計測できるというものなのでしょうか?

松元:基本的にはそうなのですが、台数が増えるとノイズも増えるので単純に増やしたからといって見栄えの良いものになるわけではありません。なので各視点を合成する際にノイズ除去のアルゴリズムを入れ、ノイズを目立たなくしています。

R:ノイズの乗りやすさであったり、点群センサーにとって得意・不得意な対象があるのですか?

松元:暗い空間や急な明暗の変化にも対応ができる点は点群の強みだと思います。画像情報から処理するボリメトリックキャプチャーは、画像の特徴量が大きく変化するのに弱いので室内の固定された照明環境に使用がある程度制限されます。対してLiDARはレーザーによるデプス情報も加味するので、通常のカメラが撮れない暗い空間でも深さが取得できます。

またボリメトリックと比較すると、点群は密度が上がらない部分はあります。ボリメトリックに使用するカメラは高精細で台数も多いので、綺麗な3Dが取れます。画素数が2Kや4Kのカメラと比較するとLiDARはセンサーが128本しかありませんから、その分密度はどうしても落ちてしまいますね。ですがその分処理速度はLiDARの方が速いので、3Dと現実が双方向で繋がるリアルタイム性を求めている我々のプロジェクトではLiDARを採用しています。

R:伝送のための圧縮などは行なっていないのでしょうか?

松元:APNの伝送的には非圧縮伝送でも問題なかったのですが、受け側のI/Oの都合で軽い可逆圧縮をかけています。ここも専用ハードウェアを作成すれば将来的に非圧縮でも問題なくなる部分だと思いますね。

R:点群チームの皆さんは2024年にもチームPerfumeと協力しての空間伝送実験(2024年9月21日に実施された配信イベント「Perfume 25th & 20th Anniversary Live Performance “IMA IMA IMA” Powered by NTT」)を実施されています。今回の取り組みはその延長線上にあるものとお見受けしますが、前回の取り組みと比較して特に進歩した点についてお聞かせいただけますか。

松元:点群を使った研究開発自体は昨年より前、2022年から取り組んできました。初めたころはオフライン処理でもグニャグニャな3Dになるようなところから始まり、少しづつ精度を上げて今回の万博実証までたどり着いています。

鈴木:2024年春の時点でまだ第一弾システムが動いてなかったですからね。昨年のお盆ごろにGPUのパワーが足りないことに気づいて、松元さんと2人で全台交換したことをよく覚えています。

松元:そんな昨年の経験を踏まえて、センサー位置の修正や点群の密度、ノイズ除去処理などは今回でも向上しています。

鈴木:前回は点群センサーが5セットでしたね。視点数を増やしても成立するような工夫も施してより綺麗になりました。

松元:同期の部分も改善しています。前回はステレオ映像から点群に乗り換える際に2,3フレーム揺らぎが発生してしまっていたんですよ。Perfumeさんのダンスの時刻精度というのは凄いもので、そのズレもシビアに影響してくるので。遅延も9月時点で300ms弱あったところから1/3の100msまで縮められました。

R:約半年で1/3もの遅延量短縮は大きいですね!どのように実現されたのですか?

松元:合計200msの短縮となると、積み上がっていくものを一つずつですね。基本的にパラレルに処理しているので、一番ボトルネックになる箇所を突き止めてその処理を工夫したり並列化を増やしたりなどです。高密度化、ノイズ除去のフィルター処理にディープラーニングを活用しての高速化も図っています。

R:前回がYouTubeでの配信だったのに対し、今回はパビリオンの物理的な空間を使った空間伝送というのも大きな違いですよね。

松元:会場で点群を何に表示するかというのも試行錯誤したポイントです。今回最終的には偏光式の3D映像をLEDに出すという、3D映像の中でもプロジェクターよりはクッキリと見える方式となったのですが、そこまでに結構な紆余曲折がありまして。小型LEDを大量に吊り下げた特殊な装置で本当に三次元的に出すという案や、水を降らして水滴にプロジェクター投射する方法、バーサライタ(点滅するLEDを回転させることによる残像で図像を表示する装置)を多層に組み合わせる案から透過スクリーンなど色々と実験しました。デバイスとしては面白いのですが、コンテンツを流すとなると難しいものも多く、決まるまでが大変でしたね。今回採用したLED方式は、 一見すると一般的な3D方式ではあるのですが、LEDによる3Dは迫力が凄く、この方式を選んでよかったと思っています。

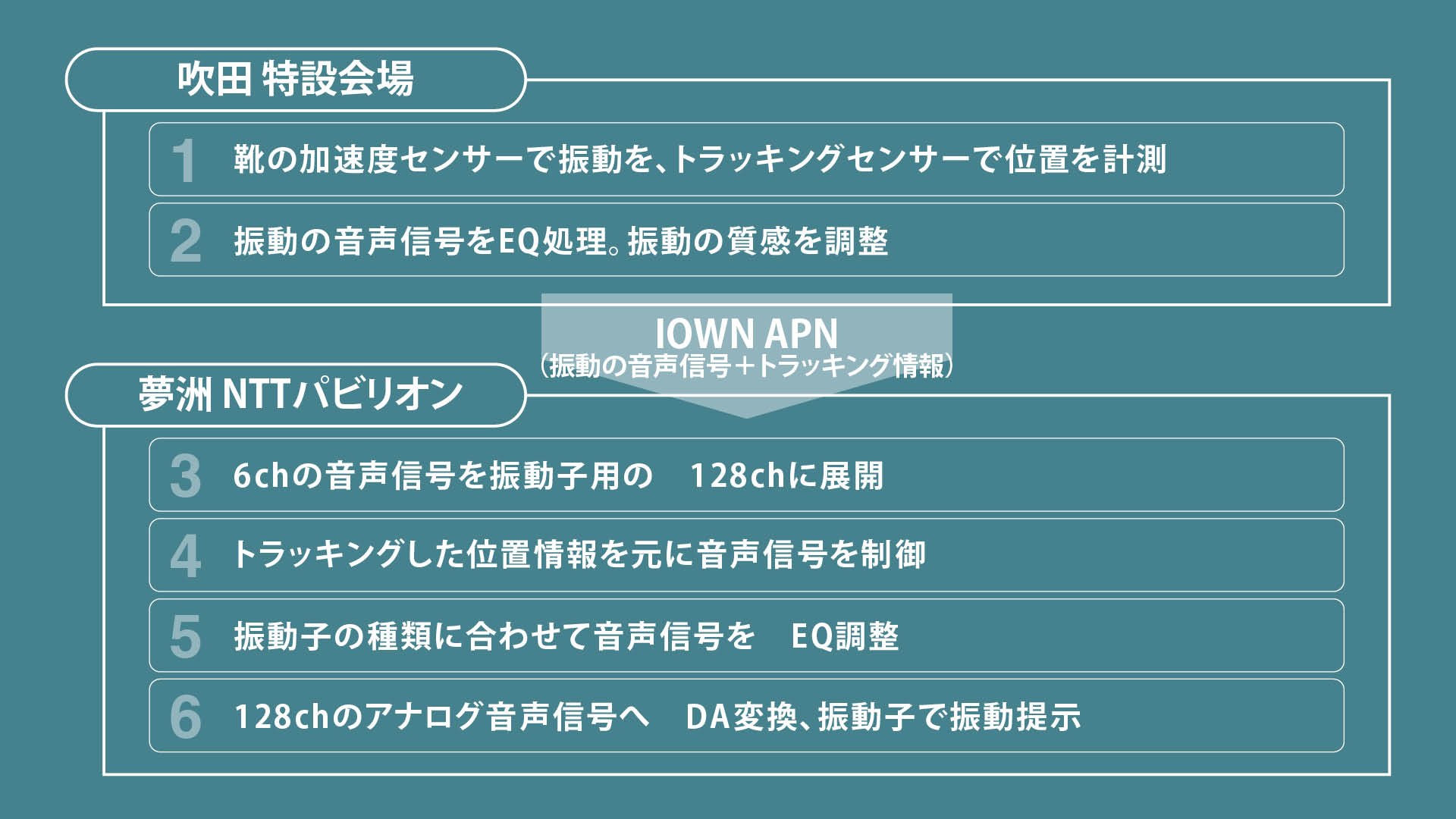

点群による3Dデータと並行して伝送されたのが、触覚振動データである。演者の靴裏には加速度センサーが取り付けられ、ダンスの足踏みによって発生する振動を音声信号としてリアルタイムに検出。それと同時に、位置トラッキング用センサーによって取得された動きの情報も含め、夢洲側へと伝送された。音声信号の伝送にはDanteによる非圧縮伝送が採用されている。受信側の会場では、床下に埋め込まれた128個の振動子が、演者の動きに同期して振動を提示。視覚・聴覚・触覚が融合したマルチモーダルな空間伝送が達成された。

R:振動の伝送では、特製の加速度センサーモジュールを用いられたようですね。

草深:当初は舞台床にマイクを埋め込む方法で考えていたのですが、パフォーマンスの妨げになる可能性やメンテナンス性などの観点から、別案件で振動を取る際に使用していた加速度センサーモジュールを利用した経緯となります。片足につき1個のセンサーで、2個(1人分)を1chとしてモノラルミックスし、合計でモノラル3chの音声データを取得しました。センサーモジュールは足音としてよい振動データが取れるよう、取り付けの構造などの工夫がされています。

R:その振動データが、トラッキングによる位置情報を元に会場側で再生されるということですね。

草深:位置のトラッキングセンサーは2種類、ビジョンベースとマーカーベースのものを採用しました。マーカーは衣装の肩甲骨のあたりに一人あたり6個仕込んでいます。マーカーの方が精度やリアルタイム性は良いのですが、髪で隠れたりなどロストする可能性もあるので、骨格の動きを検出するビジョンベースと合わせて安定性を確保しています。

📷床裏に取り付けられた大小2種類の振動子。アンプから振動子までは128本のアナログケーブルで接続。振動子それぞれの特性、用途に合わせてバックヤードに設置されたYAMAHA QL5にてレベル、EQが調整され効果的な振動を提示する。ヒールの裏面には加速度センサーが取り付けられている。

R:夢洲へIOWNで送られてきた音声信号と位置情報はどのように展開するのでしょうか。

草深:吹田からは振動のモノラル3 系統を受け取り、そこに夢洲側でダンス以外の雷や花火といった映像のSE 音源に合わせた振動の1系統を加え、計4トラックとしています。それを128chの振動子にどうルーティングするか、トラッキング情報を元に会場側でどれだけの範囲を振動させるかを制御しています。全体振動や縦方向での推移など振動のパターンを切り替えて、大人数が一度に体験できるようコントロールしていました。位置情報を扱えるUnityにてルーティング処理自体を行うPythonを制御し、さらにMaxやAbleton LiveのOSCでUnityをコントロールするといったシステムです。

R:会場側の振動子は2種類使用されていますが、どういった使い分けなのでしょうか。

草深:広い空間の中でわかりやすさと質感をどう保たせるか、という観点から2種類の併用に行き着きました。大型の振動子では振動のインパクトが稼げるのですが、もこもことした振動になります。一方、小型の振動子ではヒールのカツカツとした感じなど振動のテクスチャ感が出せます。この2種類を異なる割合で組み合わせることで良い塩梅を探っていきました。振動子の機種自体は入手性やある程度の強さが出るものを加味して選んでいます。

R:計測した振動データはEQなどによって演出的に効果的になるよう調整がなされていますが、振動のミキシングというのはどういった観点から行なっていったのでしょうか。

草深:難しかったのは映像や音が流れている中でどう振動を作っていくかですね。単純に威力のある振動を出すだけでは映像 / コンテンツから受ける印象と合わないので、振動の質感の部分がコンテンツに合うように演出チーム含めて細かく調整を詰めていきました。

松元:会場の準備段階では、今回使用させていただくのが未発表の楽曲であったというのもあり、本番音量でのテストがなかなかできなかったんですよね。限られたリハの回数で合わせていったのは凄いなと。

草深:リハで来ていただいた代役の方と本人とでも加速度の出方というのが全然違うので、そこも大変でした。またダンスによっては上手く加速度が出なかったりもします。例えば足を着くにしても普通に着くと踵とつま先で2発鳴ってしまう。そのあたりは振動として良いものになるよう演出家さんと相談させていただき、ダンスの微調整をしていただくとともに我々のEQ側でも修正を行いました。

振動は当初、コンテンツの中で邪魔にならないのが最低ラインとして、そこからもっと良いものを作るにはどうすればいいかと考えていました。それが最終的には、足音の振動によるリズムなど単純に楽曲のベースやキックを足元から出すのとは違う、新しい体験が作り出せたのでよかったです。

R:足音は音楽の拍子と必ずしも一致するものではないですが、音響・映像と合わせて一つのコンテンツとしてまとまりのあるものになっていると感じました。点群側でも演出面での工夫は何かありましたか。

松元:点群はカメラなので動き等の制約はありませんでした。以前は照明によってカメラが耐えられない箇所があったのですが、今回はカラーマトリクスの計算などかなりRAWレベルで調整できるようにしたので遜色なく撮れていると思います。

R:照明も吹田と夢洲がリンクした、二つの空間を繋ぐ効果的な演出になっていましたよね。

松元:照明スタッフは夢洲側の1人だったのですが、APNで高速に繋がっているのでリアルタイムに遠隔地を操作してそのフィードバックを映像で確認するというオペレートが実現できていました。

📷万博のパビリオン内では、ダイバーシティの取り組みとして車椅子振動共有体験デバイスも運用されている。デバイス土台のピエゾセンサーで床の振動を検知、ケーブルで接続された小型の振動子を手元や体の部位に当てることで振動を体感できる。右は振動をコントロールするQL5。

R:今回の取り組みを踏まえて、空間伝送技術で実現できる未来像についてどうお考えでしょうか。

松元:今回のようにイベントやライブで使っていただける部分もありますが、ベーシックには世の中に起きている変化をバーチャル化してデジタイズするというのがこの技術のポイントです。車の動き、交差点の歩行者の動きなどの情報を時刻情報と共に周囲のデバイスに共有することで、車のセンサーだけでは得られない情報で事故を回避するなど、実世界でアプリケーション、デバイスでこれまでできなかったことをするというのがデジタルツインの本来的な使い方です。今回はエンタメに寄った実証でしたが、3Dデータを”見る”だけでなくシミュレーション等に利用するなど、応用の方にシフトして広げていきたいなという思いがあります。

鈴木:最終的には今回の技術を家で使いたい、体験したいという要望が出てくると思うんです。今回使用したLiDARカメラはすごく大掛かりですが、それをどう家庭の環境に導入するかというところに興味があります。いきなり家に持ってくるのは厳しいので、まずは現状からセットアップを省力化する、デバイスを小型化する、実用化に必要なスペックを見極めるなどといった箇所から進めていきます。また、地球規模的に見ると世の中はやっぱりモバイルを求めているので、IOWNのような通信をどうモバイル化するかに取り組んでいきたいです。

草深:振動としては、足音振動がどこで発生しているのかを感じる方向定位知覚をより発展させていくことにも興味があります。どこから足音が鳴ってどこへ消えていくのか、ということを研究していくと「気配」のようなものを感じることがあり、今回もSNSなどで一部の観客の方からはそういった反応が見られました。そこに最近活発なイマーシブのような空間側でも、コンテンツを押し広げていくような動きと振動を組み合わせていけば、新しい体験を考えることができるのではないでしょうか。

今回の実証実験は、パフォーマンスコンテンツの未来を超えて、多様な情報によって人と人をつなぐコミュニケーションの未来の一端を体感する機会となった。また、IOWN APNが持つ大容量・高安定性・低遅延という特長は、AoIP化が進む音響業界において求められる通信インフラの要件を確実に満たしており、近い将来、音声制作のあり方を大きく変えると予測される。さらに、IOWNを活用した新たな時代の情報通信は、制作現場にとどまらず、交通、都市、家庭など私たちの実生活の中でも活用が現実味を帯びつつあることを、今回の取り組みを通じて感じていただけただろう。

1970年の大阪万博において、NTT(当時の日本電信電話公社)は、会場と日本各地を結ぶ多元生中継や、ワイヤレステレホンなど、当時の最先端電気通信技術を紹介した。今やスマートフォンひとつで世界中の人々とビデオ通話が可能な時代となったことを思えば、今回の万博で示される「未来のコミュニケーション」が現実のものとなる日も決して遠くはない。

*ProceedMagazine2025号より転載

*記事中に掲載されている情報は2025年08月19日時点のものです。